رشد نمایی فناوری هوش مصنوعی (AI)، یادگیری ماشین (ML) و یادگیری عمیق (DL) نه تنها مدلهای کسبوکار را متحول ساخته، بلکه موجب یک دگرگونی بنیادین در الزامات طراحی زیرساختهای فناوری اطلاعات شده است. دیتاسنتر هوش مصنوعی (AI Data Center)، که اغلب با نام زیرساخت AI-Ready شناخته میشود، مجموعهای تخصصی است که زیرساخت فناوری اطلاعات ویژهای را برای آموزش، استقرار و ارائه خدمات هوش مصنوعی در خود جای داده است.

اگرچه مراکز داده سنتی و دیتاسنترهای AI در نگاه اول اجزای مشابهی دارند—مانند سرورها، تجهیزات ذخیرهسازی و شبکه—اما قدرت محاسباتی و قابلیتهای زیرساختی آنها تفاوت چشمگیری را رقم میزند. این تفاوت اصلی، از ماهیت بارهای کاری (Workloads) ناشی میشود. مراکز داده سنتی (Transactional Data Centers) معمولاً برای مدیریت تراکنشهای روتین، پردازشهای ترتیبی و بارهای کاری محاسباتی متمرکز بر واحدهای پردازش مرکزی (CPU) طراحی شدهاند.

در مقابل، بارهای کاری هوش مصنوعی شامل محاسبات ماتریسی عظیم و پردازش موازی فوقسنگین است که در صدها و هزاران پردازنده توزیع میشوند. وظایف فوقسنگینی مانند آموزش مدلهای زبانی بزرگ (LLMs)، تحلیل کلانداده (Big Data) و سیستمهای یادگیری عمیق، نیازمند شتابدهندههای تخصصی هستند. زیرساختهای سنتی فاقد توان پاسخگویی به این حجم و پیچیدگی بوده و بهسرعت تحت فشار بارهای کاری هوش مصنوعی از کار میافتند. به همین دلیل، زیرساختهای AI-Ready بهجای پردازندههای رایج CPU، عمدتاً بر پایه واحدهای پردازش گرافیکی (GPUها) و واحدهای پردازش تانسور (TPUها) پیادهسازی میشوند تا کارایی بالا و مقیاسپذیری لازم را در تأمین انرژی و خنکسازی فراهم کنند.

تحول در طراحی دیتاسنتر AI فراتر از جایگزینی سختافزار است؛ این یک بازنگری کامل در معماری فیزیکی، مهندسی قدرت، و زیرساختهای ارتباطی است. این تغییر، سازمانها را ملزم میسازد تا از مدلهای قدیمی به معماریهای نوین مهاجرت کنند و الزامات E-A-T (تخصص، اعتبار و اعتماد) را در طراحی زیرساخت خود رعایت کنند تا پایداری و عملکرد در سطح جهانی تضمین شود. جدول زیر، خلاصهای از تفاوتهای کلیدی در این پارامترهای اصلی را ارائه میدهد:

Table ۱: مقایسه پارامترهای اصلی طراحی دیتاسنتر AI و سنتی

| ویژگی طراحی | دیتاسنتر سنتی (Transactional) | دیتاسنتر AI/HPC (AI-Ready) |

|---|---|---|

| واحد پردازشی غالب | CPU (پردازش ترتیبی) | GPU/TPU (پردازش موازی) |

| متوسط چگالی توان رک | ۴ تا ۶ کیلووات (kW) | ۴۰ تا ۱۴۰ کیلووات (kW) |

| روش غالب خنکسازی | هوا (Air Cooling) و CRAC/CRAH | مایع (Direct-to-Chip یا Immersion) |

| معیار ایدهآل PUE | ۱.۴ به بالا (متوسط ۱.۵۵) | ۱.۱ تا ۱.۰۵ |

| فناوری شبکه اصلی | اترنت (Ethernet) با تأخیر بالاتر | InfiniBand یا اترنت ۴۰۰GbE+ |

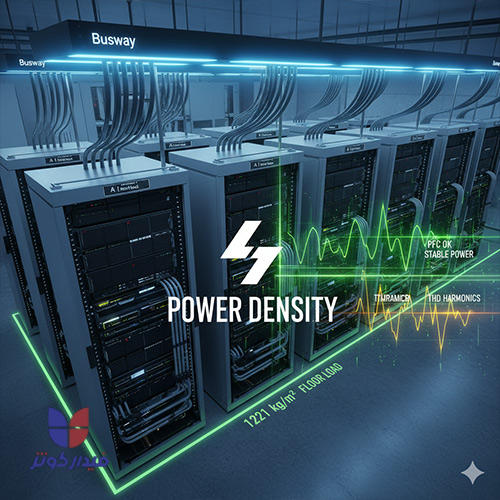

| تحمل بار کف (منطقه محاسباتی) | معمولاً ۷۰۰ kg/m² | ۱۲۲۱ kg/m² و بالاتر |

معماری محاسباتی در دیتاسنترهای AI کاملاً بر شتابدهندههایی چون GPU و TPU متمرکز است که به طور خاص برای پردازش موازی کلاندادهها و محاسبات سنگین یادگیری عمیق طراحی شدهاند. سرورهای مجهز به این شتابدهندهها، مانند سرورهای GPU نسل جدید، توان پردازشی فوقالعادهای را ارائه میدهند، اما این توان با یک چالش فیزیکی بزرگ همراه است: تولید حرارت و مصرف توان بسیار بالا.

این پردازندهها حجم گرما و توان مصرفی به مراتب بالاتری نسبت به CPUهای سنتی دارند. رکهای دیتاسنتر سنتی معمولاً برای توزیع توان ۲۰ کیلووات طراحی میشوند، در حالی که یک رک مجهز به شتابدهندههای پیشرفته AI میتواند تا ۱۴۰ کیلووات انرژی مصرف کند. این افزایش چگالی، الزامات فیزیکی خاصی را برای قفسهها (Rack) ایجاد میکند. سرورهای GPU اغلب سرورهای بزرگتر ۲U یا ۴U هستند که عمق بیشتری را در رکها طلب میکنند. بنابراین، رکها باید دارای عمق بیشتری باشند و ساختار آنها تقویت شود. همچنین، به دلیل تراکم بالای پورتها و کابلها، طراحی رکهای AI باید شامل سازوکارهای مدیریت کابل (Cable Management) قوی و سازمانیافته باشد تا جریان هوا مختل نشود و عیبیابی آسانتر باشد.

تراکم فیزیکی و وزن تجهیزات در رکهای AI، یک چالش سازهای جدی ایجاد میکند که اغلب در دیتاسنترهای سنتی نادیده گرفته میشود. یک رک مدرن مجهز به GPU و زیرساخت خنکسازی مایع، میتواند وزنی بالغ بر ۱.۵ تن یا بیشتر داشته باشد. تمرکز این وزن سنگین در یک فضای کوچک (ردپای رک) فشار زیادی را به کف دیتاسنتر وارد میکند.

در طراحی زیرساختهای AI، طراحان باید الزامات مهندسی سازه را در اولویت قرار دهند. استانداردهای فنی صریحاً بیان میکنند که دال کف اتاق کامپیوتر برای میزبانی تجهیزات اولیه با چگالی بالا، باید حداقل بار زنده کف ۱۲۲۱ کیلوگرم بر مترمربع را تحمل کند. این رقم، به مراتب بالاتر از استانداردهای بارگذاری عمومی است و مستلزم استفاده از دالهای بتنی تقویتشده است.

در صورت استفاده از کف کاذب، این کفها باید از نوع آلومینیومی مستحکم باشند و ارتفاع کافی (بین ۶۰ تا ۹۰ سانتیمتر برای تسهیل توزیع هوای سرد در صورت نیاز و عبور کابلهای سنگین) داشته باشند. توجه به این نکته ضروری است که چالش تحمل بار کف نه فقط یک الزام سازهای، بلکه مستقیماً به قابلیت اطمینان (Reliability) دیتاسنتر و جلوگیری از آسیبدیدگیهای ساختاری در هنگام استقرار تجهیزات با چگالی بالا مرتبط است.

همانطور که در بخش قبل ذکر شد، چگالی توان در دیتاسنترهای AI میتواند ۱۰ تا ۳۰ برابر بیشتر از مراکز داده سنتی باشد. این جهش در مصرف توان، زیرساخت توزیع برق را از سطح ورودی ساختمان (تابلو برق فشار متوسط) تا سطح رک (PDU) دستخوش تغییر کامل میکند.

اولین پیامد افزایش چگالی توان، ناکافی بودن سیستمهای توزیع برق سنتی است. زیرساخت باید بتواند برق را از ترانسفورماتورهای MV/LV و سیستمهای UPS با ظرفیت بسیار بالاتر دریافت کند. این امر نیاز به طراحی سیستمهای توزیع برق فوقالعاده مقاوم و مقیاسپذیر را ضروری میسازد که بتواند حجم عظیم برق مورد نیاز برای هر رک را به طور پیوسته تأمین کن

.

برای تأمین نیازهای توزیع توان در دیتاسنترهای با چگالی فوقالعاده بالا، استفاده از Busway (گذرگاههای برق) که برق را بهصورت هوایی توزیع میکنند، به یک مزیت رقابتی تبدیل شده است. برخلاف کابلکشیهای سنتی که در کف کاذب به تله میافتند، سیستمهای Busway انعطافپذیری بیشتری را برای اضافه یا حذف سریع منابع برق در محل رکها فراهم میکنند.

چالش فنی مهم دیگر، کیفیت توان است. تجهیزات محاسباتی پرقدرت AI (GPUها) بارهای غیرخطی بزرگی تولید میکنند که منجر به پدیدهای به نام اعوجاج هارمونیک کل (Total Harmonic Distortion - THD) در سیستم برق میشود. افزایش THD یک ریسک جدی برای تجهیزات الکتریکی است، زیرا میتواند باعث افزایش جریان در هادی خنثی، افزایش دمای ترانسفورماتورها و در نهایت کاهش طول عمر کل سیستم توزیع برق شود.

بنابراین، دیتاسنترهای AI نیازمند راهحلهای پیشرفته برای مدیریت این بارها هستند. پیادهسازی سیستمهای هوشمند تصحیح ضریب توان (PFC) و فیلترینگ هارمونیک، برای تضمین پایداری و کارایی انرژی در مواجهه با این بارهای غیرخطی کاملاً حیاتی است. بدون PFC، ریسک خرابی تجهیزات توزیع برق و UPSها در دیتاسنترهای AI به شدت بالا میرود.

با توجه به چگالی توان بیسابقه در رکهای AI (تا ۱۴۰ کیلووات)، سیستمهای خنککننده مبتنی بر هوا دیگر توانایی حذف مؤثر این حجم عظیم گرما را ندارند. هوا به عنوان یک محیط انتقال حرارت، ظرفیت محدودی دارد و فراتر از ۲۰ کیلووات در هر رک، خنکسازی با هوا بسیار ناکارآمد و پرهزینه میشود.

ماهیت فیزیکی مایعات این محدودیت را حل میکند. مایعات ظرفیت گرمایی بسیار بالاتری نسبت به هوا دارند؛ برای مثال، آب میتواند گرما را تا ۱۰۰۰ برابر بهتر از هوا جذب کند. این خاصیت، خنکسازی مایع را به تنها راهکار مقیاسپذیر و کارآمد برای میزبانی خوشههای GPU در دیتاسنترهای AI تبدیل کرده است.

برای مدیریت بارهای حرارتی فوقسنگین در دیتاسنتر AI، دو روش عمده خنکسازی مایع وجود دارد:

کارایی استفاده از برق (PUE) معیار کلیدی برای ارزیابی عملکرد انرژی دیتاسنتر است. هرچه PUE به عدد ایدهآل ۱ نزدیکتر باشد، نشاندهنده کارایی بالاتر و اتلاف انرژی کمتر است. در مراکز داده سنتی، PUE معمولاً بین ۱.۴ تا ۱.۶ است.

اما در دیتاسنترهای AI که از خنکسازی مایع بهره میبرند، اتلاف انرژی در سیستمهای خنککننده به طرز چشمگیری کاهش مییابد. این مراکز میتوانند به PUE در محدوده ۱.۰۵ تا ۱.۱ دست یابند. دستیابی به PUE نزدیک به ۱.۰۵ یک دستاورد بزرگ در پایداری و کاهش هزینههای عملیاتی (OpEx) است.

این تحول بر تحلیل هزینههای سرمایهای (CapEx) نیز تأثیر میگذارد. اگرچه خرید تجهیزات خنکسازی مایع اولیه گرانتر است ، اما در چگالیهای بسیار بالا (مانند ۴۰kW/rack)، به دلیل فشردهسازی بیشتر تجهیزات و کاهش نیاز به زیرساختهای بزرگ تهویه هوا و فضای ساختمانی، تحلیلها نشان دادهاند که هزینههای سرمایهای نهایی دیتاسنتر مایع میتواند تا ۱۴٪ کمتر از یک دیتاسنتر هوایی با ظرفیت محاسباتی مشابه داشته باشد. این امر به کاهش کلی هزینه مالکیت (TCO) در بلندمدت منجر میشود.

Table ۲: تحلیل کارایی حرارتی و مصرف انرژی (PUE) در سیستمهای مختلف

| سیستم خنکسازی | ظرفیت جذب گرما (نسبت به هوا) | PUE رایج | تأثیر بر فضای مورد نیاز |

|---|---|---|---|

| هوا (Air Cooling) | ۱ واحد | ۱.۴ - ۱.۶ | نیاز به راهروی سرد و گرم زیاد |

| مایع (Direct-to-Chip) | تا ۱۰۰۰ برابر | ۱.۱ - ۱.۲ | کاهش نیاز به فنهای اتاق، فضای کوچکتر |

| غوطهوری (Immersion Cooling) | بسیار بالا (جذب گرما از کل برد) | ۱.۰۵ - ۱.۱ | حداکثر فشردهسازی و تراکم رک |

بارهای کاری هوش مصنوعی نیازمند شبکهای با ظرفیت بالا، مقیاسپذیر و مهمتر از همه، با تأخیر فوقالعاده کم (Ultra-Low Latency) هستند تا بتوانند محاسبات ماتریسی بزرگ توزیع شده بین صدها یا هزاران پردازنده را به طور مؤثر مدیریت کنند.

در دیتاسنترهای سنتی، اترنت (Ethernet) رایجترین فناوری است، اما تأخیر آن (۲۰ تا ۲۰۰ میکروثانیه) برای خوشههای محاسباتی سنگین AI (HPC) بسیار زیاد تلقی میشود. فناوری InfiniBand (IB) به عنوان ستون فقرات دیتاسنترهای AI/HPC، این محدودیت را برطرف میکند. InfiniBand با تأخیر رفت و برگشت فقط ۲ تا ۱۰ میکروثانیه، کارایی شبکه را به طرز چشمگیری افزایش میدهد.

این کارایی برتر عمدتاً به دلیل استفاده InfiniBand از RDMA (Remote Direct Memory Access) است. RDMA سربار پروتکلی سنتی (مانند TCP/IP) را حذف کرده و امکان ارتباط مستقیم حافظه به حافظه بین سرورها را فراهم میآورد. این قابلیت برای انتقال حجم عظیم دادههای آموزش مدلها با سرعت ۴۰۰Gbps به بالا (InfiniBand NDR) حیاتی است و تضمین میکند که گلوگاههای شبکه مانع از سرعت پردازش GPUها نشوند

.

معماری شبکه برای خوشههای GPU در دیتاسنترهای AI از توپولوژیهای سنتی (مانند Spine-Leaf در اترنت) فراتر میرود. بارهای کاری AI نیاز به ارتباطات همهجانبه (All-to-All) دارند، که این امر مستلزم استفاده از توپولوژیهای پیشرفتهای مانند Fat-Tree و Dragonfly است. (توجه: منبع اصلی شما به این بخش ارجاع نداده است، اما این اطلاعات از تحقیق عمومی در دسترس است.)

انتخاب توپولوژی شبکه تأثیر مستقیمی بر مقیاسپذیری و کارایی الگوریتمهای یادگیری عمیق در مقیاس بزرگ دارد. یک شبکه ضعیف یا یک توپولوژی نامناسب میتواند به گرههای ارتباطی جدی منجر شود و زمان آموزش مدل را به شدت افزایش دهد. تحلیلها نشان میدهد که هیچ توپولوژی واحدی بهترین نیست، بلکه انتخاب بهینه بین Fat-Tree و Dragonfly به ویژگیهای خاص و حجم بارکاری موازی مرکز محاسباتی بستگی دارد.

برای پشتیبانی از پهنای باند فوقالعاده (۴۰۰GbE) در زیرساختهای AI، استفاده از کابلهای فیبر نوری به یک الزام تبدیل شده است، زیرا کابلهای مسی دارای محدودیتهای فاصله و سرعت هستند و به راحتی تحت تأثیر تداخلات الکترومغناطیسی قرار میگیرند. (توجه: منبع اصلی شما به این بخش ارجاع نداده است، اما این اطلاعات از تحقیق عمومی در دسترس است.)

انتقال به فیبر نوری نیازمند راهکارهای مدیریت کابل تخصصی است. فیبر نوری نسبت به خم شدن حساس است (مسئلهای که به عنوان "شعاع خمش" یا Bend Radius شناخته میشود). در رکهای GPU با تراکم بالا، استفاده از تجهیزات مدیریت کابل افقی و عمودی با حلقههای D یا نوارهای Offset ضروری است. این تجهیزات فضای کافی را برای مسیریابی کابلها فراهم میکنند و اطمینان میدهند که خمیدگی بیش از حد رخ نمیدهد، تا از افت سیگنال (Insertion Loss) یا آسیب به کابلها جلوگیری شود.

پیچیدگی فزاینده دیتاسنترهای AI، به ویژه با توجه به چگالی توان بالا، معماریهای توزیع شده و بارهای کاری پویای آنها، ابزارهای سنتی مدیریت زیرساخت مرکز داده (DCIM) را ناکارآمد میسازد. برای مدیریت مؤثر این محیطهای مدرن، نیاز به نسل بعدی سیستمهای مدیریتی، یعنی AIOps (AI for IT Operations)، ضروری است.

AIOps یک پلتفرم هوشمند است که با استفاده از یادگیری ماشین (ML) و تحلیل کلانداده، فراتر از نظارت صرف عمل میکند. هدف اصلی AIOps، افزایش سرعت و دقت در تشخیص و پیشبینی مشکلات، تحلیل ریشه اصلی خطاها (Root Cause Analysis) و در نهایت، خودکارسازی فرآیند حل آنهاست. این رویکرد به مدیران فناوری اطلاعات کمک میکند تا در محیطهای پیچیده و هیبریدی، از بروز فجایع عملیاتی جلوگیری کنند.

هوش مصنوعی در دیتاسنترهای AI به قلب عملیات نفوذ کرده و منجر به بهبودهای چشمگیری در بهرهوری و پایداری میشود:

بهینهسازی دینامیک خنکسازی: یکی از موفقترین کاربردهای AI در دیتاسنتر، کنترل سیستمهای خنککننده است. هوش مصنوعی با تحلیل بلادرنگ دادههای حسگرها و الگوهای بارکاری، میتواند سیستمهای سرمایشی را به طور خودکار تنظیم کند. این بهینهسازی دقیق نه تنها از ایجاد نقاط داغ جلوگیری میکند، بلکه مصرف انرژی سیستم خنککننده را به شدت کاهش میدهد. شرکتهایی مانند گوگل با استفاده از فناوری DeepMind توانستهاند تا ۴۰٪ در مصرف انرژی سیستمهای سرمایشی خود صرفهجویی کنند.

پیشبینی بارکاری و تخصیص منابع: AIOps قادر است با تحلیل دادههای ترافیکی و تاریخی، بارکاری آینده سیستم را پیشبینی کند. این پیشبینی به تخصیص بهینه منابع محاسباتی کمک میکند تا از مشکلات ناشی از افزایش ناگهانی بار جلوگیری شود. همچنین، هوش مصنوعی میتواند مسیرهای بهینه ترافیک شبکه را شناسایی و بهینهسازی کند و از ایجاد تنگناهای ارتباطی جلوگیری نماید.

در محیطهای محاسباتی با چگالی بالا و هزینههای عملیاتی هنگفت، خرابی ناگهانی یک تجهیز (Downtime) میتواند منجر به زیانهای مالی قابل توجهی شود. AIOps با نظارت مستمر و تحلیل دادههای سنسورهای مختلف، قادر است عمر مفید تجهیزات، مانند UPSها، سرورها یا سیستمهای خنککننده را پیشبینی کند.

استفاده از مدلهای پیشبینیکننده، به مدیران اجازه میدهد تا خرابیهای بالقوه را قبل از وقوع شناسایی کنند و اقدامات تعمیر و نگهداری پیشگیرانه را در زمان مناسب انجام دهند. این امر نه تنها قابلیت اطمینان (Reliability) و پایداری مرکز داده را افزایش میدهد، بلکه هزینههای نگهداری اضطراری را به شدت کاهش میدهد، که برای تضمین تداوم آموزش مدلهای حیاتی هوش مصنوعی الزامی است.

طراحی دیتاسنتر AI، پاسخی به تقاضای بیسابقه برای قدرت محاسباتی موازی است. این طراحی یک بازطراحی کامل از زیرساختهای فیزیکی، قدرت، خنکسازی و شبکه را میطلبد. مراکز داده سنتی به دلیل ناتوانی در مدیریت چگالی توان بالا و تأخیر کم، نمیتوانند زیرساخت مناسبی برای عصر هوش مصنوعی باشند.

تحول در طراحی دیتاسنتر AI نیازمند درک عمیق از زنجیرههای علت و معلولی است: افزایش چگالی توان (۴۰kW+) مستلزم خنکسازی مایع است، که خود مستلزم تقویت زیرساخت سازهای (تحمل بار کف ۱۲۲۱ kg/m²) و بازنگری در سیستم توزیع برق (Busway و PFC) است، و این پیچیدگیها در نهایت نیاز به مدیریت خودکار مبتنی بر AIOps برای تضمین کارایی و پایداری دارند.

PUE ایدهآل برای دیتاسنترهای مجهز به خنککننده مایع (Liquid Cooling) چقدر است؟

PUE (کارایی استفاده از برق) ایدهآل برای دیتاسنترهای AI که از خنکسازی مایع (مانند Direct-to-Chip یا Immersion Cooling) استفاده میکنند، معمولاً در محدوده ۱.۰۵ تا ۱.۱ قرار دارد. دستیابی به این رقم به معنای آن است که تقریباً تمام انرژی مصرفی (۹۰٪ تا ۹۵٪) مستقیماً صرف تجهیزات IT شده و اتلاف انرژی در سیستمهای پشتیبان (مانند خنکسازی و توزیع برق) به حداقل رسیده است.

چگالی توان رک در دیتاسنتر AI چه تفاوتی با مراکز داده سنتی دارد؟

در مراکز داده سنتی، چگالی توان رک به طور متوسط بین ۴ تا ۶ کیلووات (kW) است. اما در دیتاسنترهای AI به دلیل استفاده از شتابدهندههای GPU با مصرف بالا، چگالی توان به صورت انفجاری افزایش مییابد و به طور معمول به ۴۰ کیلووات در هر رک میرسد و در کلاسترهای HPC پیشرفته میتواند تا ۱۴۰ کیلووات یا بیشتر نیز افزایش یابد.

آیا خنکسازی مایع سرمایهگذاری اولیه (CapEx) بالاتری نسبت به خنککننده هوا دارد؟

خنکسازی مایع در مقایسه با سیستمهای هوای سنتی، نیازمند سرمایهگذاری اولیه (CapEx) بالاتری برای خرید تجهیزات تخصصی است. با این حال، در چگالیهای بالا (بالای ۲۰kW/rack)، به دلیل صرفهجویی در فضای ساختمان، کاهش شدید مصرف انرژی (OpEx) و فشردهسازی بیشتر تجهیزات، هزینههای سرمایهای نهایی دیتاسنتر مایع میتواند به دلیل نیاز کمتر به ساختار فیزیکی بزرگ و زیرساختهای مکانیکی حجیم، در نهایت ۱۴٪ کاهش نسبت به سناریوهای هوایی با ظرفیت مشابه داشته باشد.

در دنیای امروز، طراحی یک دیتاسنتر AI-Ready فراتر از یک پروژه IT است؛ یک سرمایهگذاری استراتژیک برای آینده کسبوکار شماست که نیازمند دانش عمیق در معماری HPC، خنکسازی مایع، شبکههای فوقسریع و مدیریت هوشمند است. زیرساختهای با چگالی توان بالا، چالشهای منحصربهفردی را در زمینه تحمل بار کف، مدیریت حرارتی، و کیفیت توان ایجاد میکنند. گروه تخصصی فیدار کوثر با تکیه بر دانش فنی و تجربه بینظیر، آماده است تا شما را در طراحی، پیادهسازی و بهینهسازی دیتاسنتر AI نسل آینده راهنمایی کند.

همین امروز با مشاوران ارشد فیدار کوثر تماس بگیرید و چالشهای طراحی زیرساختهای با چگالی توان بالا را به فرصتی برای پیشرفت و تضمین بازدهی سرمایهگذاری (ROI) تبدیل کنید.

بعد از ورود به حساب کاربری می توانید دیدگاه خود را ثبت کنید